K8s教程

1. 简介

1.1 什么是K8s

- 生产级别的容器编排系统

- 自动化的容器部署、扩展和管理

- Kubernetes 是用于自动部署,扩展和管理容器化应用程序的开源系统。

- 它将组成应用程序的容器组合成逻辑单元,以便于管理和服务发现。

- Kubernetes 源自Google 15 年生产环境的运维经验,同时凝聚了社区的最佳 创意和实践。

1.2 特性

Endpoint Slices Kubernetes 集群中网络端点的可扩展跟踪。

服务发现与负载均衡 无需修改您的应用程序即可使用陌生的服务发现机制。Kubernetes 为容器提供了自己的 IP 地址和一个 DNS 名称,并且可以在它们之间实现负载平衡。

自动装箱 根据资源需求和其他约束自动放置容器,同时不会牺牲可用性,将任务关键工作负载和尽力服务工作负载进行混合放置,以提高资源利用率并节省更多资源。

IPv4/IPv6 双协议栈 Allocation of IPv4 and IPv6 addresses to Pods and Services

Service 拓扑 基于集群拓扑的服务流量路由。

自我修复 重新启动失败的容器,在节点死亡时替换并重新调度容器,杀死不响应用户定义的健康检查的容器,并且在它们准备好服务之前不会将它们公布给客户端。

自动化展开和回滚 Kubernetes 会逐步推出针对应用或其配置的更改,确保在监视应用程序运行状况的同时,不会终止所有实例。如果出现问题,Kubernetes 会为您回滚更改。充分利用不断成长的部署解决方案生态系统。

水平伸缩 使用一个简单的命令、一个UI或基于CPU使用情况自动对应用程序进行伸缩。

1.3 运维部署的时代变迁(历史)

传统部署时代:

早期,组织在物理服务器上运行应用程序。无法为物理服务器中的应用程序定义资源边界,这会导致资源分配问题。例如,如果在物理服务器上运行多个应用程序,则可能会出现一个应用程序占用大部分资源的情况,结果可能导致其他应用程序的性能下降。一种解决方案是在不同的物理服务器上运行每个应用程序,但是由于资源利用不足而无法扩展,并且组织维护许多物理服务器的成本很高。

虚拟化部署时代:

作为解决方案,引入了虚拟化功能,它允许您在单个物理服务器的 CPU 上运行多个虚拟机(VM)。虚拟化功能允许应用程序在 VM 之间隔离,并提供安全级别,因为一个应用程序的信息不能被另一应用程序自由地访问。 因为虚拟化可以轻松地添加或更新应用程序、降低硬件成本等等,所以虚拟化可以更好地利用物理服务器中的资源,并可以实现更好的可伸缩性。

每个 VM 是一台完整的计算机,在虚拟化硬件之上运行所有组件,包括其自己的操作系统。

容器部署时代:

容器类似于 VM,但是它们具有轻量级的隔离属性,可以在应用程序之间共享操作系统(OS)。因此,容器被认为是轻量级的。容器与 VM 类似,具有自己的文件系统、CPU、内存、进程空间等。由于它们与基础架构分离,因此可以跨云和 OS 分发进行移植。 容器因具有许多优势而变得流行起来。下面列出了容器的一些好处:

1、 敏捷应用程序的创建和部署:与使用VM镜像相比,提高了容器镜像创建的简便性和效率; 2、 持续开发、集成和部署:通过快速简单的回滚(由于镜像不可变性),提供可靠且频繁的容器镜像构建和部署; 3、 关注开发与运维的分离:在构建/发布时而不是在部署时创建应用程序容器镜像,从而将应用程序与基础架构分离; 4、 可观察性不仅可以显示操作系统级别的信息和指标,还可以显示应用程序的运行状况和其他指标信号; 5、 跨开发、测试和生产的环境一致性:在便携式计算机上与在云中相同地运行;

云和操作系统分发的可移植性:

可在 Ubuntu、RHEL、CoreOS、本地、Google Kubernetes Engine 和其他任何地方运行。

6、 以应用程序为中心的管理:提高抽象级别,从在虚拟硬件上运行OS到使用逻辑资源在OS上运行应用程序; 7、 松散耦合、分布式、弹性、解放的微服务:应用程序被分解成较小的独立部分,并且可以动态部署和管理-而不是在一台大型单机上整体运行; 8、 资源隔离:可预测的应用程序性能; 9、 资源利用:高效率和高密度;

1.4 重要概念

1) Pod(容器组):

Pod是Kubernetes中最小的可部署单元,它是一个或多个紧密关联的容器的组合。这些容器共享相同的网络命名空间、存储资源和生命周期。Pod通常用于封装应用程序的组件,例如Web服务器、数据库或后台任务。

2) Deployment(部署):

Deployment是一种声明性的对象,用于定义Pod和副本集的规范。它描述了如何创建和更新Pod,包括所需的副本数量、Pod模板以及更新策略。Deployment提供了应用程序的声明性定义,使得管理和升级应用程序变得更加方便。

3) Service(服务)

Service是一种抽象,用于公开一组Pod作为网络服务。它为Pod提供了一个稳定的网络终结点,并通过负载均衡将流量分发到这些Pod。Service可以根据其标签选择器来选择要公开的Pod,并为它们分配一个唯一的访问IP和端口。

4) ReplicaSet(副本集

ReplicaSet确保指定数量的Pod副本正在运行。它是Deployment背后的实现机制之一。当Pod的数量少于指定的副本数量时,ReplicaSet会自动创建新的Pod副本。当Pod的数量多于指定的副本数量时,ReplicaSet会自动删除多余的Pod。

5) Namespace(命名空间)

Namespace用于在Kubernetes集群中对资源进行隔离和分组。它是一种虚拟的集群划分方式,可以将集群划分为多个逻辑部分。通过将资源放置在不同的命名空间中,可以将不同的团队、项目或环境隔离开来,提高集群的可管理性和安全性。

6) Label(标签)和 Selector(选择器)

Label是用于标识Kubernetes对象的键值对。它们可以被附加到Pod、Deployment、Service等对象上,并用于标识和组织这些对象。Selector是一种用于选择带有特定标签的对象的机制,它可以在Service、ReplicaSet等对象中使用,以确定要操作的对象集。

7) ConfigMap(配置映射)和 Secret(秘密)

ConfigMap用于存储应用程序的配置数据,例如环境变量、配置文件等。它可以在Pod中作为卷(Volume)或环境变量使用。Secret用于存储敏感信息,例如密码、API密钥等。Secrets被Base64编码并且以安全的方式传输和存储。

8) Volume(存储卷)

Volume用于在Pod和容器之间共享和持久化数据。它可以将磁盘、网络存储、主机文件系统等附加到Pod中,以便应用程序可以在其上进行读写操作。Volume使得数据在Pod重新启动或迁移时仍然可用。

9) StatefulSet(有状态副本集)

StatefulSet用于管理有状态应用程序的部署。与无状态应用程序不同,有状态应用程序具有持久性数据和唯一的网络标识。StatefulSet确保Pod按照定义的顺序和标识进行创建、更新和删除,并为每个Pod分配一个稳定的网络标识。

10) DaemonSet(守护进程集)

DaemonSet用于在集群中的每个节点上运行一个Pod的副本。它适用于需要在每个节点上运行特定任务的情况,例如日志收集、监视代理等。

11) Job和CronJob

Job用于运行一次性任务,即运行到完成的任务。CronJob基于Cron表达式定时运行任务,例如定期备份、定时清理等。

12) Ingress(入口)

Ingress是一种用于公开集群内服务的规则集合。它允许外部流量通过统一的入口访问集群中的多个服务。Ingress可以配置路由规则、SSL/TLS证书等。

1.5 组件

Master组件

Master 组件提供集群的控制平面。Master 组件对集群进行全局决策(例如,调度),并检测和响应集群事件(例如,当不满足部署的 replicas 字段时,启动新的 pod)。

Master 组件可以在集群中的任何节点上运行。然而,为了简单起见,安装脚本通常会启动同一个计算机上所有 Master 组件,并且不会在计算机上运行用户容器。

kube-apiserver

主节点上负责提供 Kubernetes API 服务的组件;它是 Kubernetes 控制面的前端。

kube-apiserver 在设计上考虑了水平扩缩的需要。 换言之,通过部署多个实例可以实现扩缩。

etcd

etcd 是兼具一致性和高可用性的键值数据库,可以作为保存 Kubernetes 所有集群数据的后台数据库。

您的 Kubernetes 集群的 etcd 数据库通常需要有个备份计划。

kube-scheduler

主节点上的组件,该组件监视那些新创建的未指定运行节点的 Pod,并选择节点让 Pod 在上面运行。

调度决策考虑的因素包括单个 Pod 和 Pod 集合的资源需求、硬件/软件/策略约束、亲和性和反亲和性规范、数据位置、工作负载间的干扰和最后时限。

kube-controller-manager

在主节点上运行控制器的组件,从逻辑上讲,每个控制器都是一个单独的进程,但是为了降低复杂性,它们都被编译到同一个可执行文件,并在一个进程中运行。

这些控制器包括:

节点控制器(Node Controller): 负责在节点出现故障时进行通知和响应。 副本控制器(Replication Controller): 负责为系统中的每个副本控制器对象维护正确数量的 Pod。 端点控制器(Endpoints Controller): 填充端点(Endpoints)对象(即加入 Service 与 Pod)。 服务帐户和令牌控制器(Service Account & Token Controllers): 为新的命名空间创建默认帐户和 API 访问令牌.

云控制器管理器-(cloud-controller-manager)

- 运行与基础云提供商交互的控制器。cloud-controller-manager 二进制文件是 Kubernetes 1.6 版本中引入的 alpha 功能。

- 仅运行云提供商特定的控制器循环。您必须在 kube-controller-manager 中禁用这些控制器循环,您可以通过在启动 kube-controller-manager 时将 --cloud-provider 参数设置为 external 来禁用控制器循环。

- 允许云供应商的代码和 Kubernetes 代码彼此独立地发展。在以前的版本中,核心的 Kubernetes 代码依赖于特定云提供商的代码来实现功能。在将来的版本中,云供应商专有的代码应由云供应商自己维护,并与运行 Kubernetes 的云控制器管理器相关联。

以下控制器具有云提供商依赖性:

节点控制器(Node Controller): 用于检查云提供商以确定节点是否在云中停止响应后被删除 路由控制器(Route Controller): 用于在底层云基础架构中设置路由 服务控制器(Service Controller): 用于创建、更新和删除云提供商负载均衡器 数据卷控制器(Volume Controller): 用于创建、附加和装载卷、并与云提供商进行交互以编排卷

Node 组件

节点组件在每个节点上运行,维护运行的 Pod 并提供 Kubernetes 运行环境。

kubelet

一个在集群中每个节点上运行的代理。它保证容器都运行在 Pod 中。

kubelet 接收一组通过各类机制提供给它的 PodSpecs,确保这些 PodSpecs 中描述的容器处于运行状态且健康。kubelet 不会管理不是由 Kubernetes 创建的容器。

kube-proxy

- kube-proxy 是集群中每个节点上运行的网络代理,实现 Kubernetes Service 概念的一部分。

- kube-proxy 维护节点上的网络规则。这些网络规则允许从集群内部或外部的网络会话与 Pod 进行网络通信。

- 如果有 kube-proxy 可用,它将使用操作系统数据包过滤层。否则,kube-proxy 会转发流量本身。

容器运行环境(Container Runtime)

容器运行环境是负责运行容器的软件。

Kubernetes 支持多个容器运行环境: Docker、 containerd、cri-o、 rktlet 以及任何实现 Kubernetes CRI (容器运行环境接口)。

插件(Addons)

插件使用 Kubernetes 资源 (DaemonSet确保 Pod 的副本在集群中的一组节点上运行。, Deployment等) 实现集群功能。因为这些提供集群级别的功能,所以插件的命名空间资源属于 kube-system 命名空间。

DNS

- 尽管并非严格要求其他附加组件,但所有示例都依赖集群 DNS,因此所有 Kubernetes 集群都应具有 DNS。

- 除了您环境中的其他 DNS 服务器之外,集群 DNS 还是一个 DNS 服务器,它为 Kubernetes 服务提供 DNS 记录。

- Cluster DNS 是一个 DNS 服务器,和您部署环境中的其他 DNS 服务器一起工作,为 Kubernetes 服务提供DNS记录。

- Kubernetes 启动的容器自动将 DNS 服务器包含在 DNS 搜索中。

用户界面(Dashboard)

Dashboard 是 Kubernetes 集群的通用基于 Web 的 UI。它使用户可以管理集群中运行的应用程序以及集群本身并进行故障排除。

容器资源监控

容器资源监控将关于容器的一些常见的时间序列度量值保存到一个集中的数据库中,并提供用于浏览这些数据的界面。

集群层面日志

集群层面日志 机制负责将容器的日志数据保存到一个集中的日志存储中,该存储能够提供搜索和浏览接口。

2. 入门

2.1 安装

k8s安装——ubuntu_ubuntu安装k8s-CSDN博客

1. 安装-docker

/etc/docker/daemon.json下的。 docker的默认驱动为cgroupfs,同步docker驱动到kubelet的默认驱动systemd

{

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "100m"

},

"storage-driver": "overlay2"

}systemctl enable docker

systemctl daemon-reload

systemctl restart docker2. 准备环境

# 禁用交换分区(在旧版的 k8s 中 kubelet 都要求关闭 swapoff ,但最新版的 kubelet 其实已经支持 swap ,因此这一步其实可以不做。)

swapoff -a

# 永久禁用,打开/etc/fstab注释掉swap那一行。

sudo vim /etc/fstab

# 修改内核参数(首先确认你的系统已经加载了 br_netfilter 模块,默认是没有该模块的,需要你先安装 bridge-utils)

apt-get install -y bridge-utils

modprobe br_netfilter

lsmod | grep br_netfilter

# 如果报错找不到包,需要先更新 apt-get update -y关闭 Linux 的 swap 分区

sudo swapoff -a

sudo sed -ri '/\sswap\s/s/^#?/#/' /etc/fstabroot用户

swapoff -a

sed -ri '/\sswap\s/s/^#?/#/' /etc/fstab修改 iptables 配置

cat <<EOF | sudo tee /etc/modules-load.d/k8s.conf

br_netfilter

EOF

cat <<EOF | sudo tee /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.ipv4.ip_forward=1 # better than modify /etc/sysctl.conf

EOF

sudo sysctl --system3. 安装kubeadm,kubelet,kubectl

sudo apt install -y apt-transport-https ca-certificates curl

curl https://mirrors.aliyun.com/kubernetes/apt/doc/apt-key.gpg | sudo apt-key add -

cat <<EOF | sudo tee /etc/apt/sources.list.d/kubernetes.list

deb https://mirrors.aliyun.com/kubernetes/apt/ kubernetes-xenial main

EOF

sudo apt update

sudo apt install -y kubeadm=1.23.17-00 kubelet=1.23.17-00 kubectl=1.23.17-00

# 锁定版本

sudo apt-mark hold kubeadm kubelet kubectlroot用户

apt install -y apt-transport-https ca-certificates curl

curl https://mirrors.aliyun.com/kubernetes/apt/doc/apt-key.gpg | apt-key add -

cat <<EOF | tee /etc/apt/sources.list.d/kubernetes.list

deb https://mirrors.aliyun.com/kubernetes/apt/ kubernetes-xenial main

EOF

apt update

apt install -y kubeadm=1.23.17-00 kubelet=1.23.17-00 kubectl=1.23.17-00

# 锁定版本

apt-mark hold kubeadm kubelet kubectl卸载命令

apt-get remove kubeadm kubelet kubectl安装如果报错的话,需要先卸载原有的kubectl、kubeadm、kubelet 然后再执行安装

4. 安装Kubernetes 组件镜像(可选)

以下的情况是针对访问k8s镜像失败的情况

首先查看kubeadm config 依赖的images有哪些:

#查看kubeadm config所需的镜像

kubeadm config images list结果

#执行结果如下

registry.k8s.io/kube-apiserver:v1.23.17

registry.k8s.io/kube-controller-manager:v1.23.17

registry.k8s.io/kube-scheduler:v1.23.17

registry.k8s.io/kube-proxy:v1.23.17

registry.k8s.io/pause:3.6

registry.k8s.io/etcd:3.5.6-0

registry.k8s.io/coredns/coredns:v1.8.6然后从国内镜像拉取这些镜像

docker pull registry.aliyuncs.com/google_containers/kube-apiserver:v1.23.17

docker pull registry.aliyuncs.com/google_containers/kube-controller-manager:v1.23.17

docker pull registry.aliyuncs.com/google_containers/kube-scheduler:v1.23.17

docker pull registry.aliyuncs.com/google_containers/kube-proxy:v1.23.17

docker pull registry.aliyuncs.com/google_containers/pause:3.6

docker pull registry.aliyuncs.com/google_containers/etcd:3.5.6-0

docker pull registry.aliyuncs.com/google_containers/coredns/coredns:v1.8.6然后根据(1)中的依赖对这些镜像进行重命名(这里要注意重命名的版本号有的是带v的,有的是不带的)注意看清楚。

将下面的脚本拷贝进文件,然后执行文件即可

#!/bin/bash

repo=registry.aliyuncs.com/google_containers

for name in `kubeadm config images list --kubernetes-version v1.23.17`; do

src_name=${name#registry.k8s.io/}

src_name=${src_name#coredns/}

docker pull $repo/$src_name

docker tag $repo/$src_name $name

docker rmi $repo/$src_name

done有这些镜像就行

5. 安装master节点

sudo kubeadm init \

--pod-network-cidr=10.10.0.0/16 \

--image-repository registry.aliyuncs.com/google_containers \ # 如果已经提前下载了 Kubernetes 组件镜像,可以忽略这个参数

--apiserver-advertise-address=172.30.0.3 \ # 这里需要替换成本机的 IP

--kubernetes-version=v1.23.3自己运行

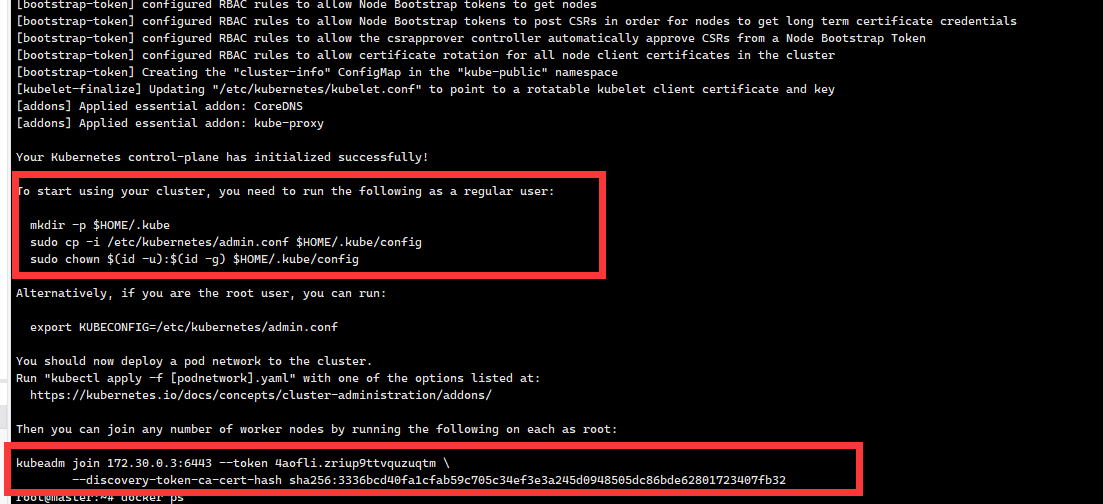

kubeadm init --pod-network-cidr=10.10.0.0/16 --apiserver-advertise-address=172.30.0.3 --kubernetes-version=v1.23.17kubeadm init 成功之后,按照在终端上看到的提示操作即可

To start using your cluster, you need to run the following as a regular user:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config然后按照要求 运行以下命令

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config另外还有一个很重要的“kubeadm join”提示,其他节点要加入集群必须要用指令里的 token 和 ca 证书,所以这条命令务必拷贝后保存好

Then you can join any number of worker nodes by running the following on each as root:

kubeadm join XXX.XXX.XXX.XXX:XXX --token XXXXXX.XXXXXXXXXXXXXXXXXX \

--discovery-token-ca-cert-hash sha256:XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX

如果没有保存,也没有关系🐶,可以使用下面的命令重新获取到

sudo kubeadm token create --print-join-command然后运行

kubectl get nodes在master执行,即可看到节点已为Ready状态

安装报错

删除 /etc/kubernetes/ 所有配置文件

cd /etc/kubernetes/

rm -rf *如果此处报错,则需要重启 即可

kubeadm reset6. 安装 Flannel 网络插件

kubectl apply -f kube-flannel.ymlkube-flannel.yml 的内容如下

apiVersion: v1

kind: Namespace

metadata:

labels:

k8s-app: flannel

pod-security.kubernetes.io/enforce: privileged

name: kube-flannel

---

apiVersion: v1

kind: ServiceAccount

metadata:

labels:

k8s-app: flannel

name: flannel

namespace: kube-flannel

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

labels:

k8s-app: flannel

name: flannel

rules:

- apiGroups:

- ""

resources:

- pods

verbs:

- get

- apiGroups:

- ""

resources:

- nodes

verbs:

- get

- list

- watch

- apiGroups:

- ""

resources:

- nodes/status

verbs:

- patch

- apiGroups:

- networking.k8s.io

resources:

- clustercidrs

verbs:

- list

- watch

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

labels:

k8s-app: flannel

name: flannel

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: flannel

subjects:

- kind: ServiceAccount

name: flannel

namespace: kube-flannel

---

apiVersion: v1

data:

cni-conf.json: |

{

"name": "cbr0",

"cniVersion": "0.3.1",

"plugins": [

{

"type": "flannel",

"delegate": {

"hairpinMode": true,

"isDefaultGateway": true

}

},

{

"type": "portmap",

"capabilities": {

"portMappings": true

}

}

]

}

net-conf.json: |

{

"Network": "10.10.0.0/16",

"Backend": {

"Type": "vxlan"

}

}

kind: ConfigMap

metadata:

labels:

app: flannel

k8s-app: flannel

tier: node

name: kube-flannel-cfg

namespace: kube-flannel

---

apiVersion: apps/v1

kind: DaemonSet

metadata:

labels:

app: flannel

k8s-app: flannel

tier: node

name: kube-flannel-ds

namespace: kube-flannel

spec:

selector:

matchLabels:

app: flannel

k8s-app: flannel

template:

metadata:

labels:

app: flannel

k8s-app: flannel

tier: node

spec:

affinity:

nodeAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

nodeSelectorTerms:

- matchExpressions:

- key: kubernetes.io/os

operator: In

values:

- linux

containers:

- args:

- --ip-masq

- --kube-subnet-mgr

command:

- /opt/bin/flanneld

env:

- name: POD_NAME

valueFrom:

fieldRef:

fieldPath: metadata.name

- name: POD_NAMESPACE

valueFrom:

fieldRef:

fieldPath: metadata.namespace

- name: EVENT_QUEUE_DEPTH

value: "5000"

image: docker.io/flannel/flannel:v0.22.0

name: kube-flannel

resources:

requests:

cpu: 100m

memory: 50Mi

securityContext:

capabilities:

add:

- NET_ADMIN

- NET_RAW

privileged: false

volumeMounts:

- mountPath: /run/flannel

name: run

- mountPath: /etc/kube-flannel/

name: flannel-cfg

- mountPath: /run/xtables.lock

name: xtables-lock

hostNetwork: true

initContainers:

- args:

- -f

- /flannel

- /opt/cni/bin/flannel

command:

- cp

image: docker.io/flannel/flannel-cni-plugin:v1.1.2

name: install-cni-plugin

volumeMounts:

- mountPath: /opt/cni/bin

name: cni-plugin

- args:

- -f

- /etc/kube-flannel/cni-conf.json

- /etc/cni/net.d/10-flannel.conflist

command:

- cp

image: docker.io/flannel/flannel:v0.22.0

name: install-cni

volumeMounts:

- mountPath: /etc/cni/net.d

name: cni

- mountPath: /etc/kube-flannel/

name: flannel-cfg

priorityClassName: system-node-critical

serviceAccountName: flannel

tolerations:

- effect: NoSchedule

operator: Exists

volumes:

- hostPath:

path: /run/flannel

name: run

- hostPath:

path: /opt/cni/bin

name: cni-plugin

- hostPath:

path: /etc/cni/net.d

name: cni

- configMap:

name: kube-flannel-cfg

name: flannel-cfg

- hostPath:

path: /run/xtables.lock

type: FileOrCreate

name: xtables-lock7. 安装worker节点

sodu kubeadm join XXX.XXX.XXX.XXX:XXX --token XXXXXX.XXXXXXXXXXXXXXXXXX \

--discovery-token-ca-cert-hash sha256:XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX2.2 kubesphere安装

基于 KubeSphere 玩转 k8s|30 分钟 Ubuntu 22.04 安装 KubeSphere 实战入门 - 知乎 (zhihu.com)